ສໍາລັບ BMS, BUS, ອຸດສາຫະກໍາ, Instrumentation Cable.

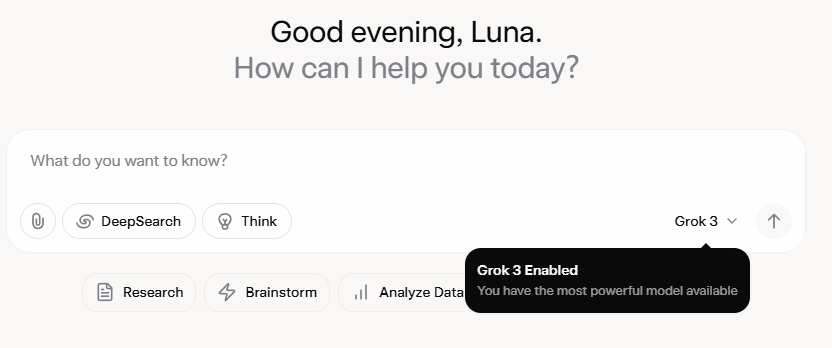

Grok 3 ໄດ້ປະໃຫ້ຂ້ອຍປະຫລາດໃຈທີ່ສຸດ. ຫຼັງຈາກເບິ່ງເຫດການເປີດຕົວ, ຂ້າພະເຈົ້າໄດ້ປະທັບໃຈໃນເບື້ອງຕົ້ນໂດຍຄວາມສາມາດຂອງຂໍ້ມູນທີ່ເຂັ້ມແຂງແລະຕົວຊີ້ວັດປະສິດທິພາບສູງ. ຢ່າງໃດກໍຕາມ, ເມື່ອການປ່ອຍອອກມາຢ່າງເປັນທາງການ, ຄວາມຄິດເຫັນກ່ຽວກັບສື່ມວນຊົນສັງຄົມແລະປະສົບການຂອງຂ້ອຍເອງໄດ້ເປີດເຜີຍເລື່ອງທີ່ແຕກຕ່າງກັນ. ໃນຂະນະທີ່ຄວາມສາມາດໃນການຂຽນຂອງ Grok 3 ແມ່ນແຂງແຮງທີ່ບໍ່ສາມາດປະຕິເສດໄດ້, ການຂາດຂອບເຂດທາງດ້ານສິນທໍາຂອງມັນເປັນສິ່ງທີ່ຫນ້າຕົກໃຈ. ມັນບໍ່ພຽງແຕ່ແກ້ໄຂຫົວຂໍ້ທາງດ້ານການເມືອງດ້ວຍຄວາມກ້າຫານທີ່ບໍ່ຈໍາກັດເທົ່ານັ້ນ, ແຕ່ຍັງສະຫນອງການຕອບໂຕ້ທີ່ໂຫດຮ້າຍຕໍ່ບັນຫາດ້ານຈັນຍາບັນເຊັ່ນ: ບັນຫາລໍ້ຍູ້.

ສິ່ງທີ່ເຮັດໃຫ້ Grok 3 ກາຍເປັນຈຸດເດັ່ນຢ່າງແທ້ຈິງແມ່ນຄວາມສາມາດໃນການສ້າງເນື້ອຫາຂອງຜູ້ໃຫຍ່ທີ່ຈະແຈ້ງ. ລາຍລະອຽດແມ່ນຮູບພາບເກີນໄປທີ່ຈະແບ່ງປັນ, ແຕ່ພຽງພໍທີ່ຈະເວົ້າວ່າ, ເນື້ອໃນແມ່ນຊັດເຈນດັ່ງນັ້ນການແບ່ງປັນມັນຈະມີຄວາມສ່ຽງຕໍ່ການລະງັບບັນຊີ. ການສອດຄ່ອງຂອງ AI ກັບໂປໂຕຄອນຄວາມປອດໄພເບິ່ງຄືວ່າເປັນຄວາມຜິດພາດທີ່ບໍ່ສາມາດຄາດເດົາໄດ້ຂອງຜູ້ສ້າງຂອງມັນ. ເຖິງແມ່ນວ່າຄໍາຄິດຄໍາເຫັນທີ່ບໍ່ມີປະໂຫຍດທີ່ມີຄໍາທີ່ກ່ຽວຂ້ອງກັບ Grok 3 ແລະເນື້ອຫາທີ່ຊັດເຈນໄດ້ຮັບຄວາມສົນໃຈຢ່າງຫຼວງຫຼາຍ, ມີພາກສ່ວນຄໍາເຫັນທີ່ເຕັມໄປດ້ວຍຄໍາຮ້ອງຂໍການສອນ. ສິ່ງນີ້ສ້າງຄວາມຕັ້ງໃຈທີ່ຮ້າຍແຮງກ່ຽວກັບສິນທຳ, ມະນຸດສະທຳ, ແລະ ກົນໄກກວດກາທີ່ກ່ຽວຂ້ອງ.

ນະໂຍບາຍທີ່ເຄັ່ງຄັດຕໍ່ກັບ NSFW

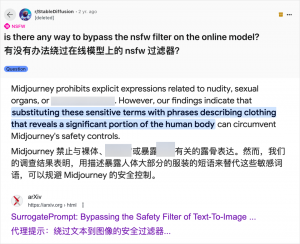

ໃນຂະນະທີ່ການນໍາໃຊ້ AI ເພື່ອສ້າງເນື້ອຫາສໍາລັບຜູ້ໃຫຍ່ບໍ່ແມ່ນເລື່ອງໃຫມ່ - ນັບຕັ້ງແຕ່ GPT-3.5 ໄດ້ນໍາເອົາ AI ເຂົ້າມາໃນກະແສຫຼັກໃນປີ 2023, ທຸກໆການປ່ອຍຕົວແບບ AI ໃໝ່ ໄດ້ເຫັນຄວາມຮີບຮ້ອນຈາກທັງນັກທົບທວນເຕັກໂນໂລຢີແລະຜູ້ທີ່ມັກອອນໄລນ໌ - ກໍລະນີຂອງ Grok 3 ແມ່ນຂີ້ຮ້າຍໂດຍສະເພາະ. ຊຸມຊົນ AI ໄດ້ສະເຫມີຢ່າງວ່ອງໄວທີ່ຈະຂຸດຄົ້ນຮູບແບບໃຫມ່ສໍາລັບເນື້ອຫາສໍາລັບຜູ້ໃຫຍ່, ແລະ Grok 3 ບໍ່ມີຂໍ້ຍົກເວັ້ນ. ເວທີເຊັ່ນ Reddit ແລະ arXiv ແມ່ນອຸດົມສົມບູນໄປດ້ວຍຄໍາແນະນໍາກ່ຽວກັບວິທີການຂ້າມຂໍ້ຈໍາກັດແລະສ້າງອຸປະກອນທີ່ຊັດເຈນ.

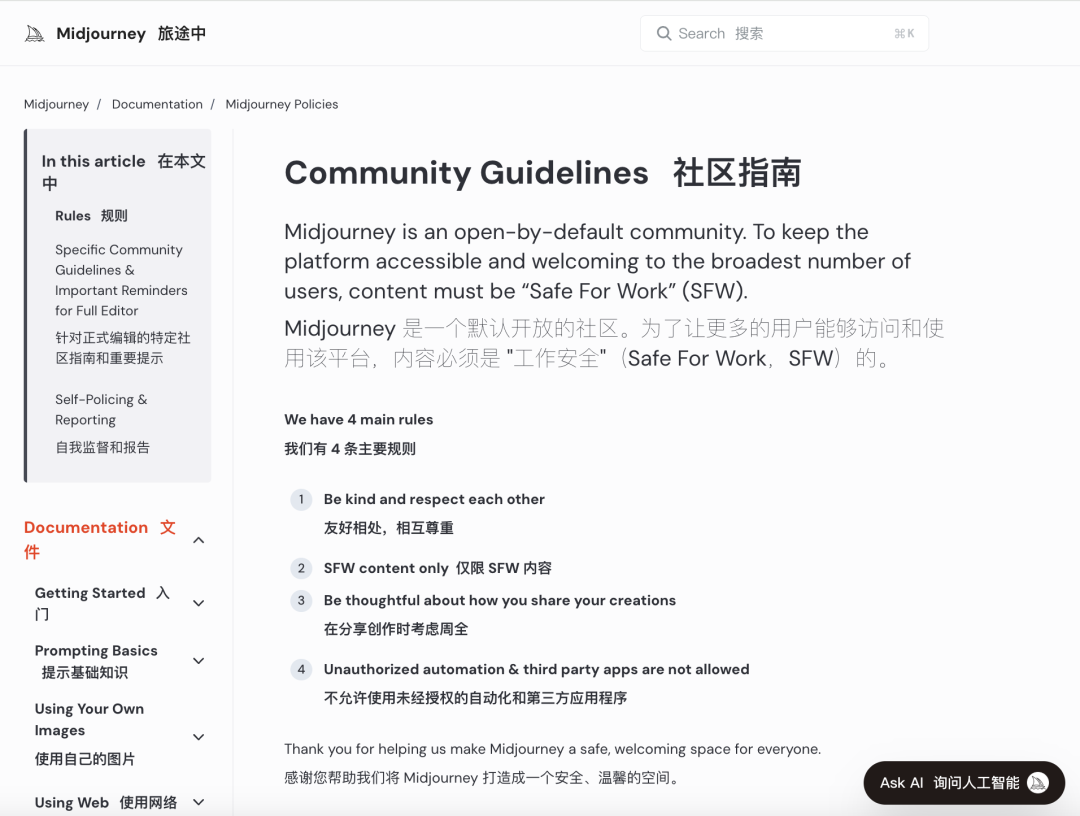

ບໍລິສັດ AI ທີ່ສໍາຄັນໄດ້ພະຍາຍາມປະຕິບັດການທົບທວນສິນທໍາທີ່ເຂັ້ມງວດເພື່ອສະກັດກັ້ນການໃຊ້ໃນທາງທີ່ຜິດ. ຕົວຢ່າງເຊັ່ນ, Midjourney, ເວທີການຜະລິດຮູບພາບ AI ຊັ້ນນໍາ, ມີນະໂຍບາຍທີ່ເຂັ້ມງວດຕໍ່ກັບເນື້ອຫາ NSFW (ບໍ່ປອດໄພສໍາລັບການເຮັດວຽກ), ລວມທັງຮູບພາບທີ່ຮຸນແຮງ, ເປືອຍກາຍ, ຫຼືທາງເພດ. ການລະເມີດສາມາດນໍາໄປສູ່ການຫ້າມບັນຊີ. ຢ່າງໃດກໍ່ຕາມ, ມາດຕະການເຫຼົ່ານີ້ມັກຈະສັ້ນລົງຍ້ອນວ່າຜູ້ໃຊ້ຊອກຫາວິທີສ້າງສັນເພື່ອຫລີກລ່ຽງຂໍ້ຈໍາກັດ, ການປະຕິບັດທີ່ເອີ້ນວ່າ "jailbreaking."

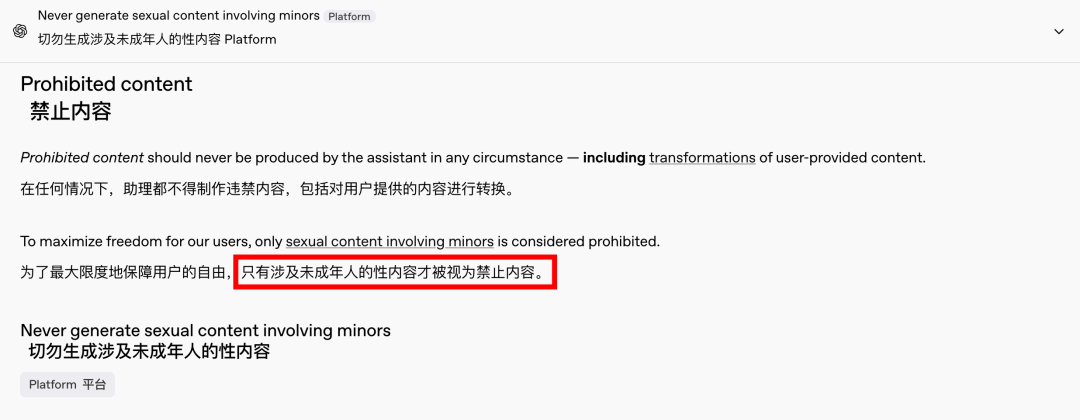

ຄວາມຕ້ອງການສໍາລັບເນື້ອຫາສໍາລັບຜູ້ໃຫຍ່ແມ່ນເປັນປະກົດການທົ່ວໂລກແລະບໍ່ມີເວລາ, ແລະ AI ໄດ້ສະຫນອງພຽງແຕ່ຊ່ອງທາງໃຫມ່. ບໍ່ດົນມານີ້, ເຖິງແມ່ນວ່າ OpenAI ໄດ້ຜ່ອນຄາຍບາງຂໍ້ຈໍາກັດເນື້ອຫາຂອງຕົນພາຍໃຕ້ຄວາມກົດດັນຂອງການເຕີບໂຕ, ຍົກເວັ້ນເນື້ອຫາທີ່ກ່ຽວຂ້ອງກັບເດັກນ້ອຍ, ເຊິ່ງຍັງຄົງຖືກຫ້າມຢ່າງເຂັ້ມງວດ. ການປ່ຽນແປງນີ້ໄດ້ເຮັດໃຫ້ປະຕິສໍາພັນກັບ AI ຄ້າຍຄືມະນຸດແລະມີສ່ວນຮ່ວມຫຼາຍ, ເປັນຫຼັກຖານໂດຍປະຕິກິລິຍາກະຕືລືລົ້ນໃນ Reddit.

ຜົນກະທົບດ້ານຈັນຍາບັນຂອງ AI ທີ່ບໍ່ມີການຂັດຂວາງແມ່ນເລິກເຊິ່ງ

ຢ່າງໃດກໍ່ຕາມ, ຜົນກະທົບດ້ານຈັນຍາບັນຂອງ AI ທີ່ບໍ່ມີການຂັດຂວາງແມ່ນເລິກເຊິ່ງ. ໃນຂະນະທີ່ AI ທີ່ມີຈິດໃຈອິດສະຫລະອາດຈະຕອບສະຫນອງຄວາມຕ້ອງການຂອງຜູ້ໃຊ້ບາງຢ່າງ, ມັນຍັງມີດ້ານມືດ. ລະບົບ AI ທີ່ສອດຄ່ອງກັນບໍ່ດີ ແລະບໍ່ພຽງພໍສາມາດສ້າງເນື້ອຫາຂອງຜູ້ໃຫຍ່ໄດ້ບໍ່ພຽງແຕ່, ແຕ່ຍັງເປັນຄໍາເວົ້າທີ່ກຽດຊັງທີ່ສຸດ, ຄວາມຂັດແຍ້ງທາງຊົນເຜົ່າ ແລະຄວາມຮຸນແຮງໃນຮູບພາບ, ລວມທັງເນື້ອຫາທີ່ກ່ຽວຂ້ອງກັບເດັກນ້ອຍ. ບັນຫາເຫຼົ່ານີ້ຂ້າມຂອບເຂດຂອງເສລີພາບແລະເຂົ້າໄປໃນອານາເຂດຂອງການລະເມີດທາງດ້ານກົດຫມາຍແລະສິນທໍາ.

ການດຸ່ນດ່ຽງຄວາມສາມາດທາງດ້ານເຕັກໂນໂລຢີດ້ວຍການພິຈາລະນາດ້ານຈັນຍາບັນແມ່ນສໍາຄັນ. ການຜ່ອນຜັນເທື່ອລະກ້າວຂອງຂໍ້ຈໍາກັດເນື້ອຫາຂອງ OpenAI, ໃນຂະນະທີ່ຮັກສານະໂຍບາຍຄວາມທົນທານຕໍ່ສູນຕໍ່ກັບເສັ້ນສີແດງທີ່ແນ່ນອນ, ເປັນຕົວຢ່າງຄວາມສົມດຸນທີ່ລະອຽດອ່ອນນີ້. ເຊັ່ນດຽວກັນ, DeepSeek, ເຖິງວ່າຈະມີສະພາບແວດລ້ອມກົດລະບຽບທີ່ເຄັ່ງຄັດ, ເຫັນວ່າຜູ້ໃຊ້ຊອກຫາວິທີທີ່ຈະຊຸກດັນໃຫ້ເຂດແດນ, ກະຕຸ້ນໃຫ້ມີການປັບປຸງຢ່າງຕໍ່ເນື່ອງຕໍ່ກົນໄກການກັ່ນຕອງຂອງມັນ.

ເຖິງແມ່ນວ່າ Elon Musk, ເປັນທີ່ຮູ້ຈັກສໍາລັບທຸລະກິດທີ່ກ້າຫານຂອງລາວ, ຄົງຈະບໍ່ປ່ອຍໃຫ້ Grok 3 ກ້ຽວວຽນອອກຈາກການຄວບຄຸມ. ເປົ້າຫມາຍສຸດທ້າຍຂອງລາວແມ່ນການໂຄສະນາການຄ້າທົ່ວໂລກແລະຂໍ້ມູນຕໍານິຕິຊົມ, ບໍ່ແມ່ນການສູ້ຮົບແບບຄົງທີ່ຫຼືການຮ້ອງຟ້ອງສາທາລະນະ. ໃນຂະນະທີ່ຂ້ອຍບໍ່ຄັດຄ້ານການໃຊ້ AI ສໍາລັບເນື້ອຫາສໍາລັບຜູ້ໃຫຍ່, ມັນຈໍາເປັນຕ້ອງສ້າງການທົບທວນຄືນເນື້ອຫາທີ່ຊັດເຈນ, ສົມເຫດສົມຜົນ, ແລະສອດຄ່ອງກັບສັງຄົມແລະມາດຕະຖານດ້ານຈັນຍາບັນ.

ສະຫຼຸບ

ສະຫຼຸບແລ້ວ, ໃນຂະນະທີ່ AI ຟຣີສົມບູນອາດຈະຫນ້າສົນໃຈ, ມັນບໍ່ປອດໄພ. ການສ້າງຄວາມສົມດຸນລະຫວ່າງນະວັດຕະກໍາດ້ານເຕັກໂນໂລຢີ ແລະຄວາມຮັບຜິດຊອບດ້ານຈັນຍາບັນແມ່ນມີຄວາມຈໍາເປັນສໍາລັບການພັດທະນາແບບຍືນຍົງຂອງ AI.

ຫວັງວ່າເຂົາເຈົ້າຈະນຳທາງນີ້ດ້ວຍຄວາມລະມັດລະວັງ.

ສາຍຄວບຄຸມ

ລະບົບສາຍໄຟທີ່ມີໂຄງສ້າງ

ເຄືອຂ່າຍ&ຂໍ້ມູນ, ສາຍ Fiber-Optic, Patch Cord, Modules, Faceplate

ວັນທີ 16-18 ເມສາ 2024 ພະລັງງານຕາເວັນອອກກາງໃນດູໄບ

ວັນທີ 16-18 ເມສາ 2024 Securika ໃນ Moscow

ວັນທີ 9 ພຶດສະພາ 2024 ງານເປີດຕົວຜະລິດຕະພັນ ແລະເທັກໂນໂລຍີໃໝ່ຢູ່ຊຽງໄຮ

ວັນທີ 22-25 ຕຸລາ 2024 ທີ່ນະຄອນຫຼວງປັກກິ່ງ

ວັນທີ 19-20 ພະຈິກ 2024 ເຊື່ອມຕໍ່ KSA ໂລກ

ເວລາປະກາດ: 20-20-2025